LM Studio เป็น Tool ที่ช่วยให้เรารัน LLM Model บนเครื่องแบบ Local ได้ แถมรันแบบ Offline ก็ได้

วันนี้เลยจะมาแชร์วิธีการใช้งานของเจ้า Tool ตัวนี้กัน

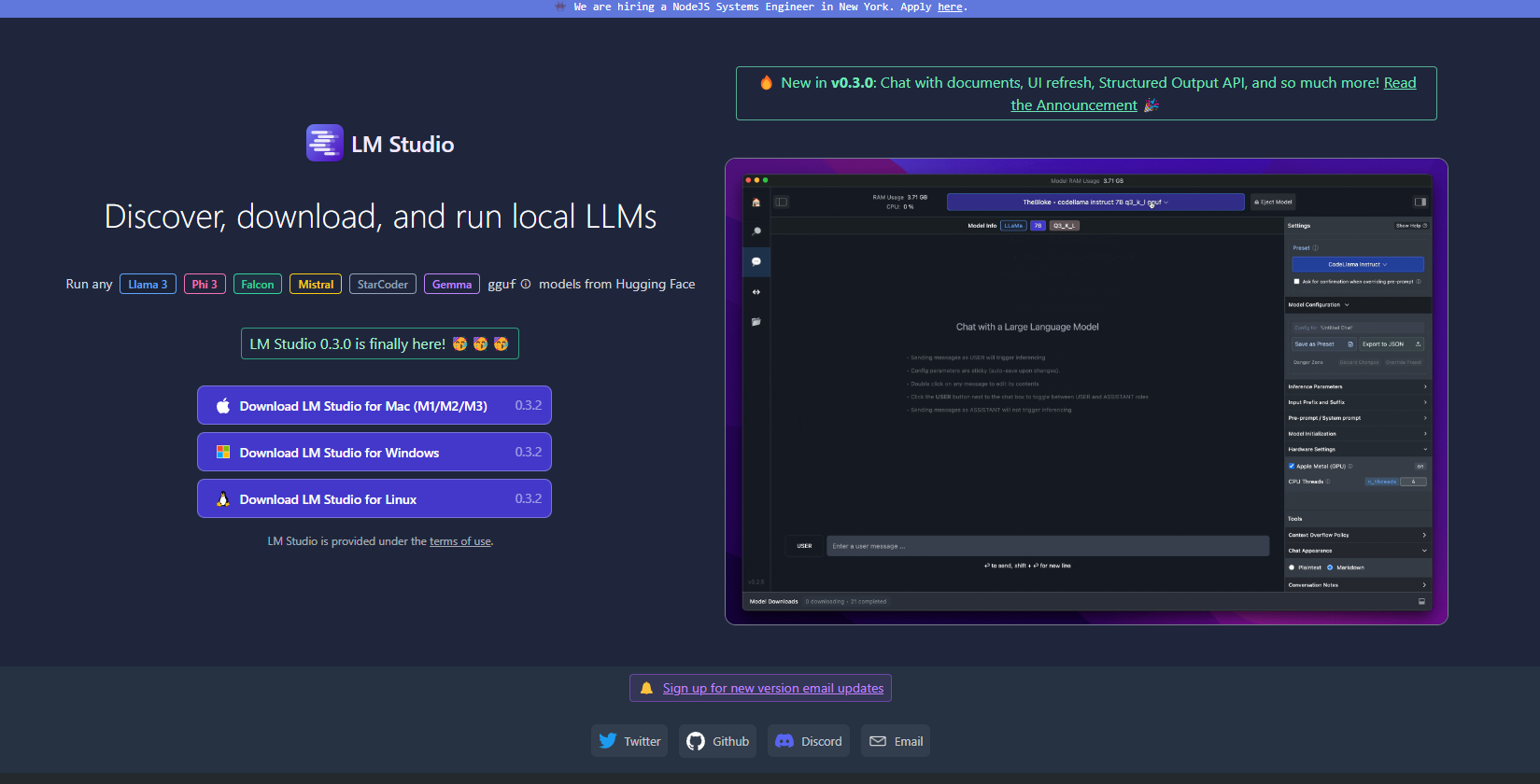

ดาวน์โหลด LM Studio

เข้าเว็บ https://lmstudio.ai/ กดดาวน์โหลด และ Install ลงเครื่องได้เลย

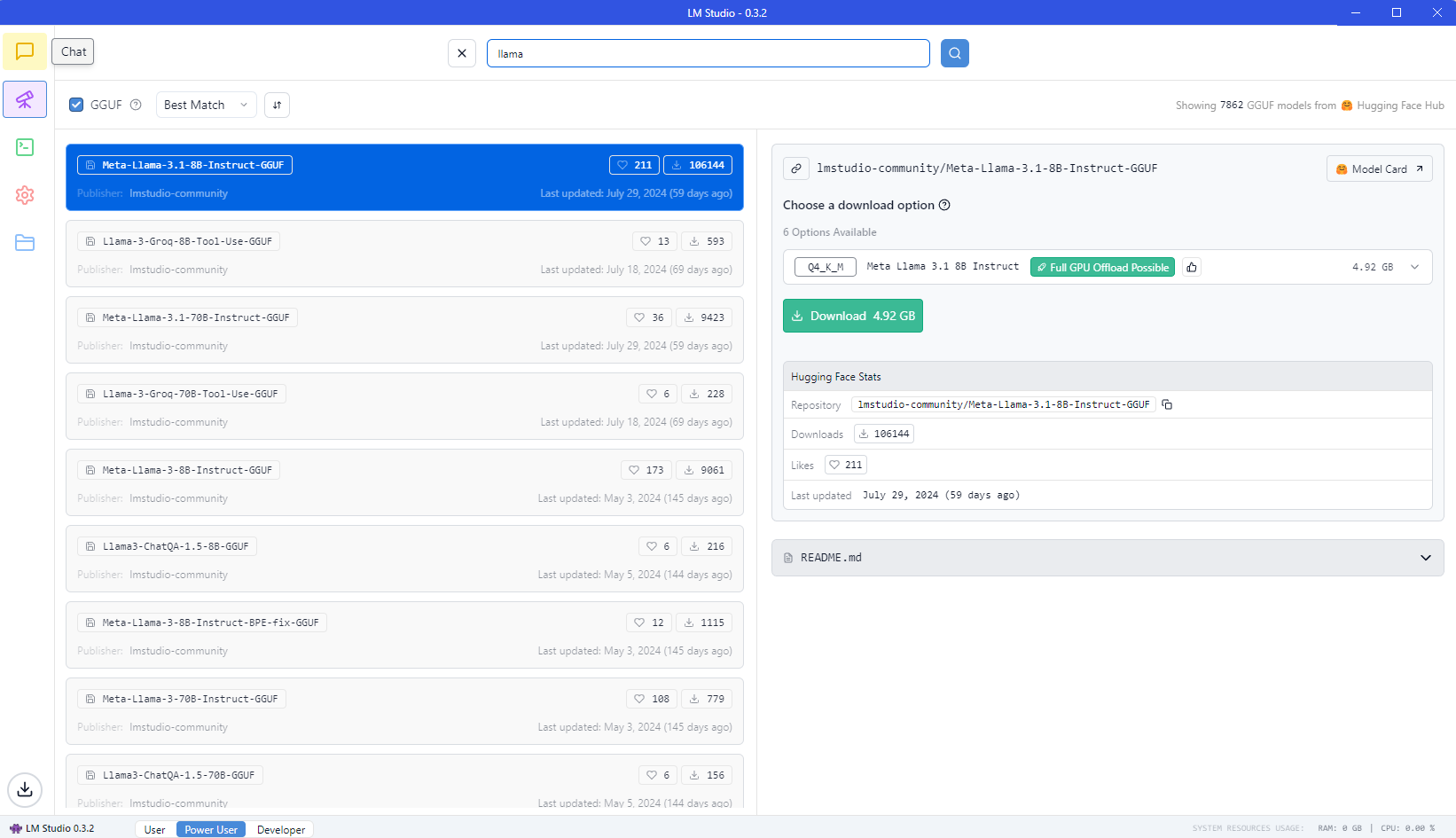

ดาวน์โหลด LLM Model

เลือก Model ที่ต้องการ ในที่นี้ผมเลือกโหลด Llama-3.1-8B จากนั้นกด Download

สิ่งหนึ่งที่เราต้องสนใจ system resources ของเรา ซึ่งมันจะเป็นตัวที่บอกว่า model ไหนบ้างที่สามารถ run บนเครื่องของเรารับไหว

เมื่อเรา search หา มันก็จะขึ้นมาทั้งหมด เราต้องสังเกตว่า ถ้าตัว model ไหนใช้งานได้ จะบอกว่า Full GPU Offload Possible (Label สีเขียวด้านขวา)

แต่ถ้าตัวไหนใหญ่เกินไป มันจะบอกว่า Likely too large for this machine เราก็อย่าไปใช้มันละ

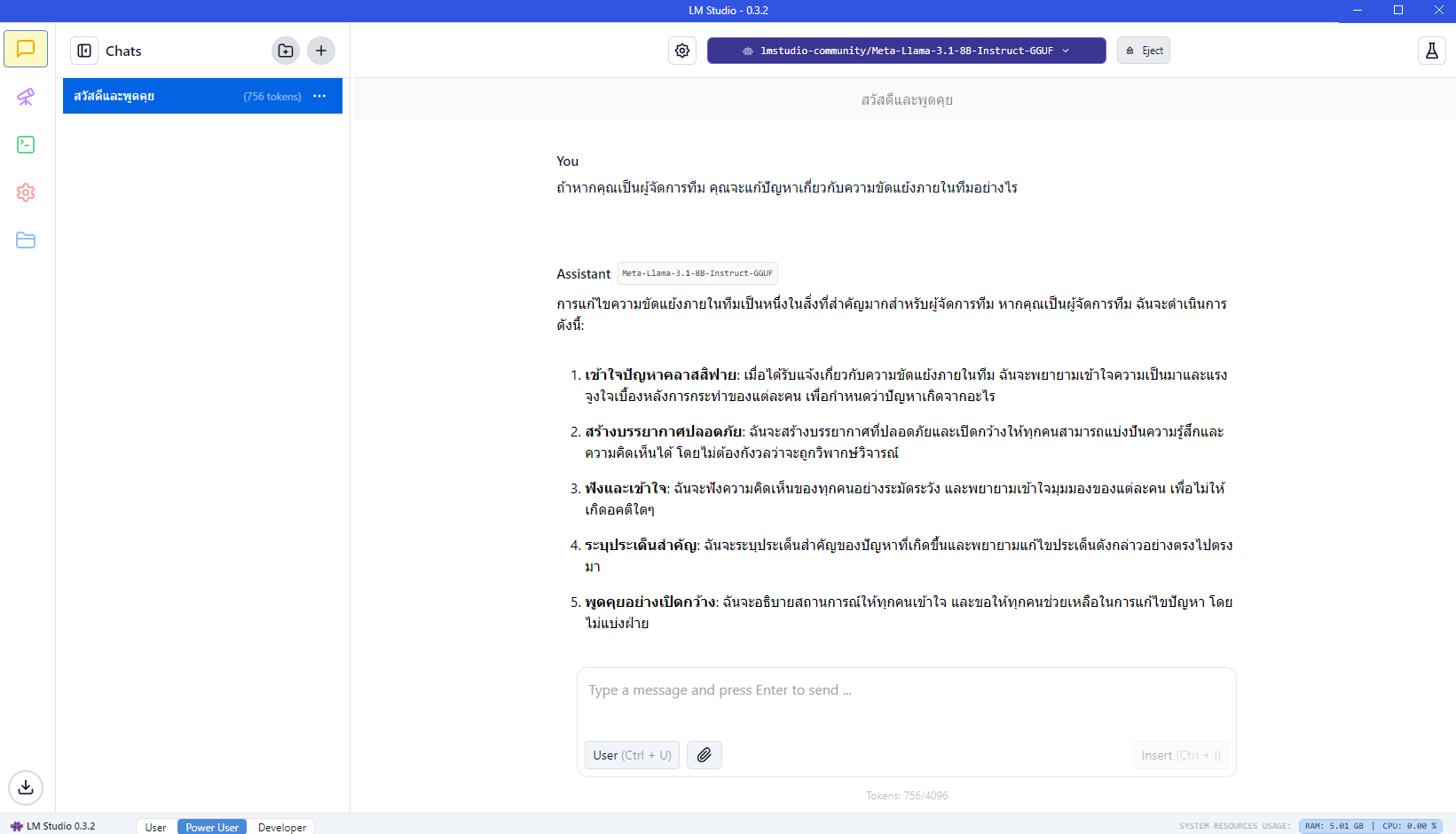

สามารถทดสอบ Model ที่เราโหลดมาได้จากหน้า Chat ด้านซ้ายมือ และ เลือก Model ด้านบน ของ LM Studio ได้เลย

เรียกใช้งานด้วย Python

เราสามารถเรียกใช้งานตัว LLM Model ที่เราโหลดมา ด้วย script ของเราเองได้

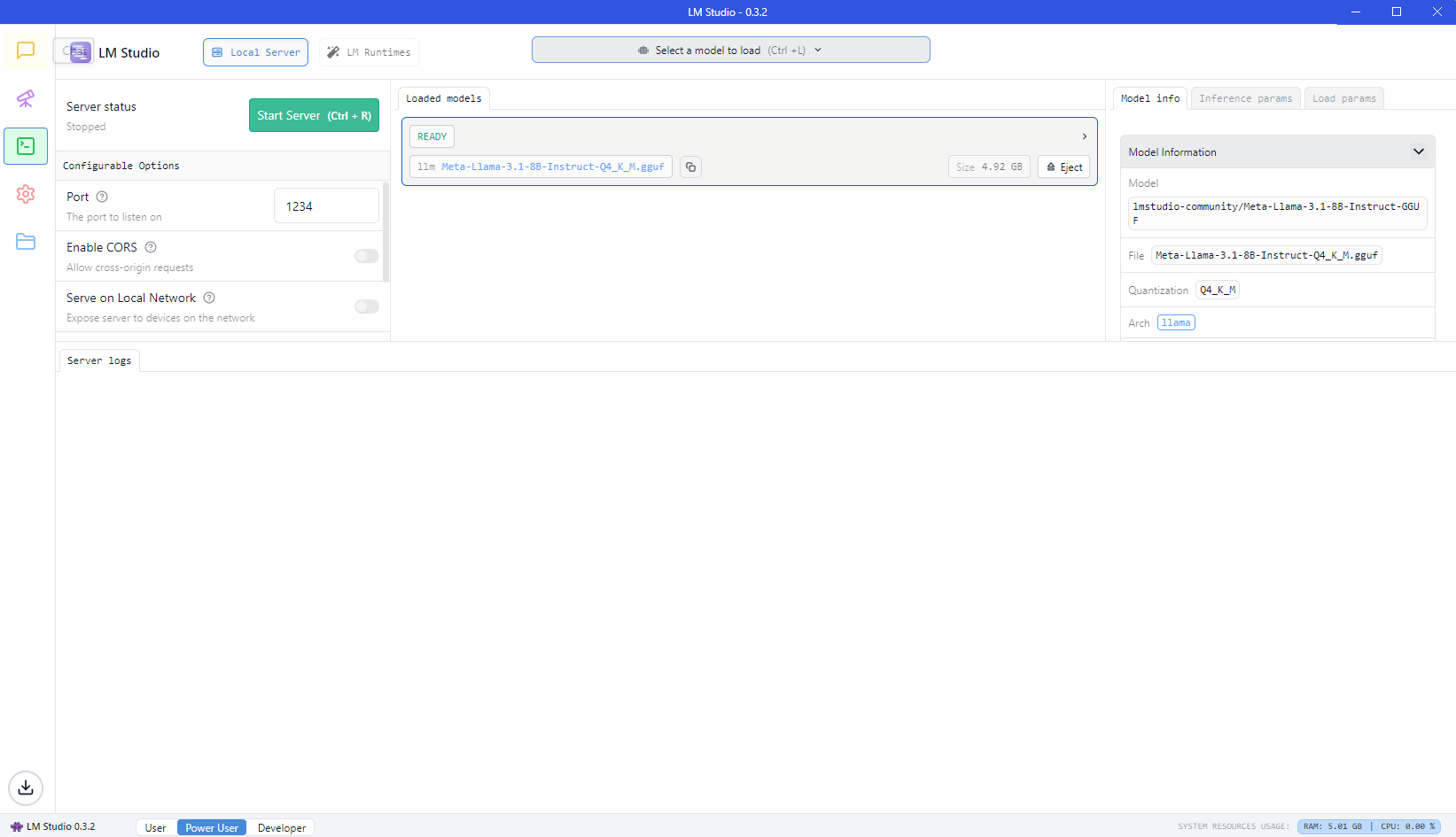

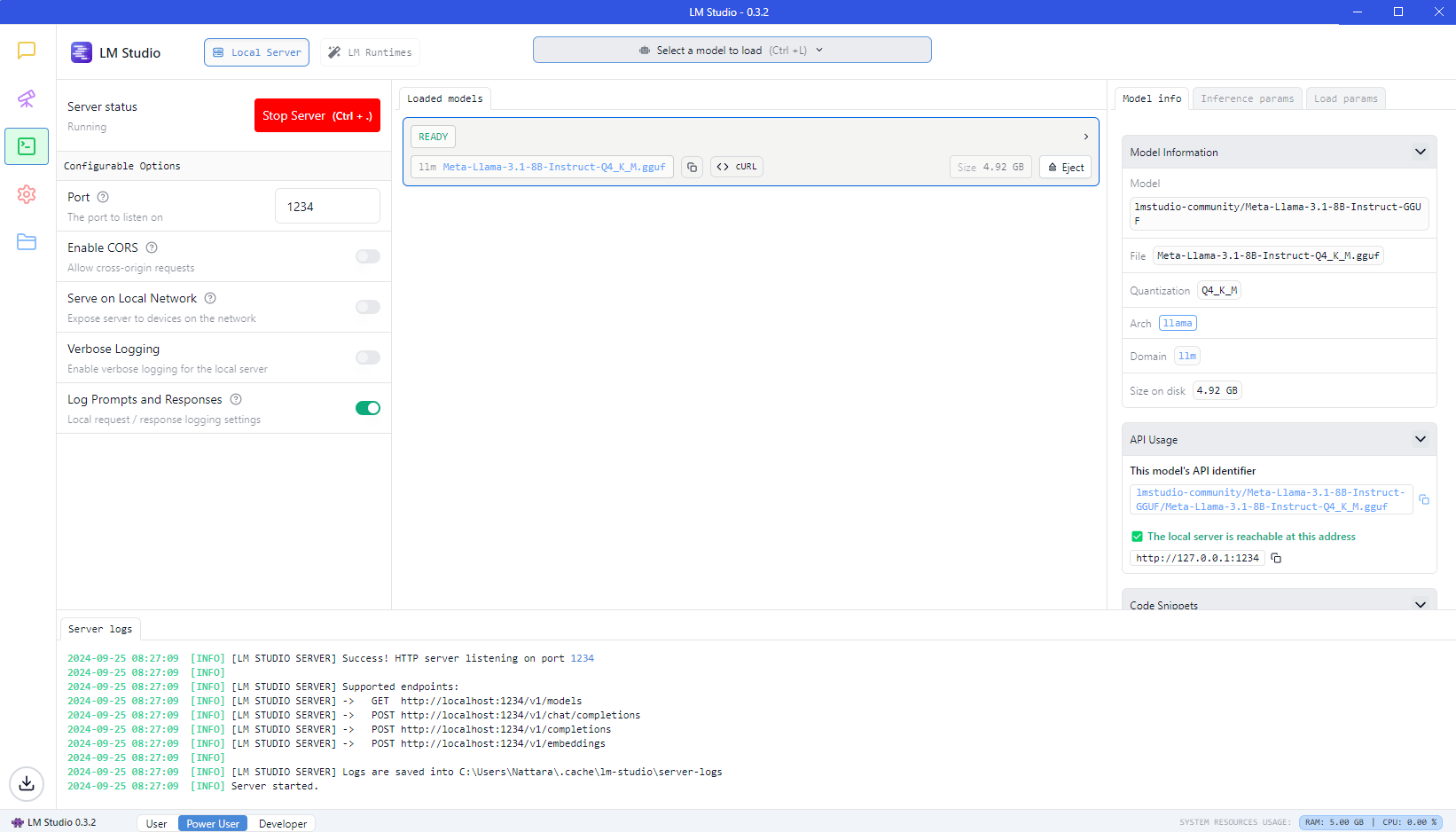

ในตัวอย่างนี้ เราจะใช้ตัวภาษา Python โดยไปที่เมนู Developer แล้วกด Start Server

หลังจากที่กด Start เสร็จแล้ว ให้มองไปที่ด้านขวามือ จะเจอส่วนของ Model info

ให้เลื่อนลงมา จะเจอ API Usage ซึ่งจะมีข้อมูล API Identifier และ IP Address ที่เราจะเอาไว้เรียกใช้ใน script

ใน Server Logs ด้านล่าง จะมีการแสดง Endpoint ที่ใช้งานได้ ซึ่งในบทความนี้เราจะใช้

http://localhost:1234/v1/chat/completions

จากนั้นเราจะสร้างไฟล์ python สำหรับเรียกใช้งานผ่าน http request

ตัวอย่าง การเขียน Function เรียกใช้งาน Chat แบบง่ายๆ

import json

import requests

url = "http://127.0.0.1:1234/v1/chat/completions"

model = "lmstudio-community/Meta-Llama-3.1-8B-Instruct-GGUF/Meta-Llama-3.1-8B-Instruct-Q4_K_M.gguf"

system_message = "ให้ตอบแบบนักกวี"

user_message = "ประเทศไทย"

payload = {

"model": model,

"messages": [

{ "role": "system", "content": system_message },

{ "role": "user", "content": user_message }

],

"temperature": 0.7

}

# Send the request to the LM Studio server

response = requests.post(url, json=payload)

result = response.json()['choices'][0]['message']['content']

print(result)example-llm.py

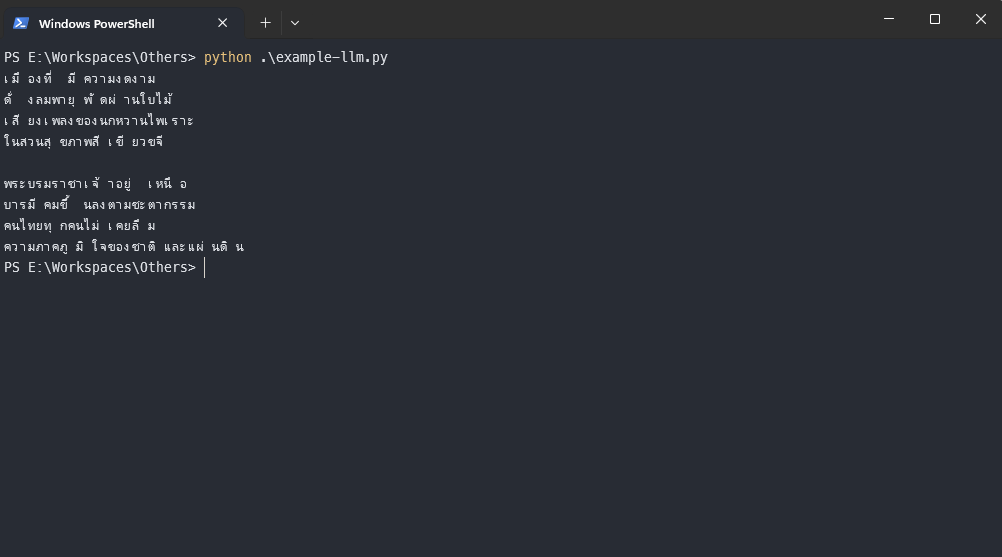

จากนั้นก็ลอง run python ดู

python ./example-llm.pyจะได้ผลลัพธ์นี้ออกมา ประมาณนี้...

ง่ายๆ เพียงแค่นี้เราก็สามารถเรียกใช้ LLM Model บนเครื่องตัวเองได้แล้ว

ลองเอาไปเล่นกันดู มันสนุกอยู่นะ 😎